在數位時代,網站的排名與可搜尋性成為影響線上成功的關鍵因素。這就是搜尋引擎最佳化(SEO)技術崛起的原因。其中,Robots.txt是SEO的一個重要元素,它指導搜尋引擎爬蟲如何瀏覽和索引網站。儘管其功能顯得如此重要,許多人卻對Robots.txt的使用和設定感到困惑。本文將深入探討Robots.txt的介紹,它如何影響網路爬蟲,並提供設定指引以及在SEO中的影響,讓您的網站在搜尋引擎中獲得更好的排名。

簡介 – Robots.txt的定義與功能

當我們在網路上搜尋資訊時,搜索引擎會透過爬蟲程式自動瀏覽各個網站,收集相關內容並建立索引。這使得我們可以從龐大的網路資訊中迅速找到所需的內容。而在此過程中,有一個小而強大的工具扮演著關鍵角色,那就是Robots.txt。

Robots.txt是一種網站上的文本檔案,它告訴搜尋引擎爬蟲哪些部分的網站應該被爬取,哪些部分不應該被爬取。它的主要目的是防止網站中某些部分被爬蟲訪問,可能是因為這些部分包含了敏感信息,或者是為了避免網站伺服器因過度被爬蟲訪問而過載。每個網站的Robots.txt文件都應該放在網站的根目錄下

例如:http://www.example.com/robots.txt

以便搜尋引擎爬蟲能夠找到並遵循其規則。

Robots.txt 對於爬蟲的影響

Robots.txt 與搜索引擎爬蟲的關係

Robots.txt檔案在告訴搜索引擎爬蟲如何訪問你的網站時扮演著關鍵的角色。當爬蟲訪問一個網站時,它會首先檢查Robots.txt檔案來決定哪些內容可以被索引,哪些不可以。也就是說,Robots.txt是一種用來優化你的網站內容,並指導爬蟲如何有效瀏覽你的網站的工具。

以下是一些常見的搜尋引擎爬蟲名稱與其相對應的User-agent:

- Googlebot:Google 的爬蟲,用於抓取網站上的內容以便在Google搜尋結果中顯示。在robots.txt中,我們可以使用 “User-agent: Googlebot” 來指定與Googlebot相關的規則。

- Bingbot:Bing 的爬蟲,與Googlebot的功能相似,但是用於Bing的搜索結果。在robots.txt中,我們可以使用 “User-agent: Bingbot” 來指定與Bingbot相關的規則。

- Slurp:Yahoo 的爬蟲,負責抓取網站資訊供Yahoo搜索使用。在robots.txt中,我們可以使用 “User-agent: Slurp” 來指定與Slurp相關的規則。

- DuckDuckBot:DuckDuckGo 的爬蟲,用於為DuckDuckGo搜索引擎抓取資訊。在robots.txt中,我們可以使用 “User-agent: DuckDuckBot” 來指定與DuckDuckBot相關的規則。

- Baiduspider:百度的爬蟲,專為中國最大的搜尋引擎百度抓取網頁資訊。在robots.txt中,我們可以使用 “User-agent: Baiduspider” 來指定與Baiduspider相關的規則。

透過了解這些常見的爬蟲名稱與相應的User-agent,我們可以更精確地制定我們的robots.txt,進一步優化我們的網站在各搜尋引擎中的表現。

Robots.txt的範例說明:如何限制Bing爬蟲的速度

要限制特定搜索引擎的爬蟲速度,你可以在Robots.txt文件中使用”Crawl-delay”指令。例如,如果你希望Bing的爬蟲在訪問你的網站頁面之間等待至少10秒,你可以如下設定你的Robots.txt:

User-agent: bingbot

Crawl-delay: 10

在上面的範例中,”User-agent”是指定哪種爬蟲的指令,”bingbot”是Bing的爬蟲名稱,而”Crawl-delay”則是設定爬蟲在訪問不同頁面之間應該等待的時間,單位為秒。透過這種方式,你可以有效控制爬蟲訪問你網站的頻率,防止伺服器負載過大,下面我會有更多的範例說明。

如何設定Robots.txt

設定Robots.txt並不困難,即使你沒有程式背景也可以輕易完成。接下來我們將教你如何設定Robots.txt,並將著重在txt檔的指令範例,Yoast SEO以及Rank Math的設定。

Robots.txt的基本指令

一個基本的Robots.txt文件可以包括以下指令:

User-agent: [爬蟲名稱]

Disallow: [不允許爬蟲訪問的URL或路徑]

Allow: [允許爬蟲訪問的URL或路徑]

Crawl-delay: [爬蟲訪問的間隔時間]

這些指令告訴爬蟲哪些頁面或路徑可以爬取,哪些不可以,以及在兩次爬取之間應該等待多長時間。

以下是一個如何在Robots.txt中設定只允許Googlebot爬取你的/includes/目錄,但不允許其他搜尋蜘蛛爬取的範例:

User-agent: Googlebot

Allow: /includes/

User-agent: *

Disallow: /includes/

在這個範例中,第一個指令 “User-agent: Googlebot” 跟隨著 “Allow: /includes/”,意味著只有Googlebot可以爬取你的/includes/目錄。第三個指令 “User-agent: ” 指的是所有其他的爬蟲,跟隨著 “Disallow: /includes/”,這表示除了Googlebot以外的所有爬蟲都被禁止爬取你的/includes/目錄。’‘ 符號在這裡代表所有的爬蟲。

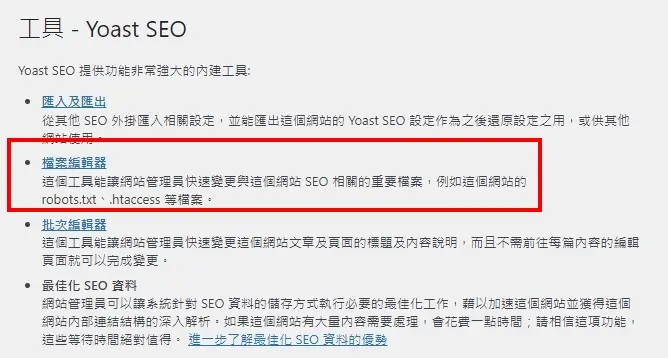

使用Yoast SEO設定Robots.txt

Yoast SEO是一款極受歡迎的WordPress SEO插件,它提供了一個簡單的介面來編輯你的Robots.txt檔案。首先,你需要在WordPress後台導航到SEO > 工具 > 檔案編輯器,然後你就可以在這裡看到你的Robots.txt文件。你可以添加、編輯或刪除任何規則,然後按下”保存變更”來更新你的Robots.txt。

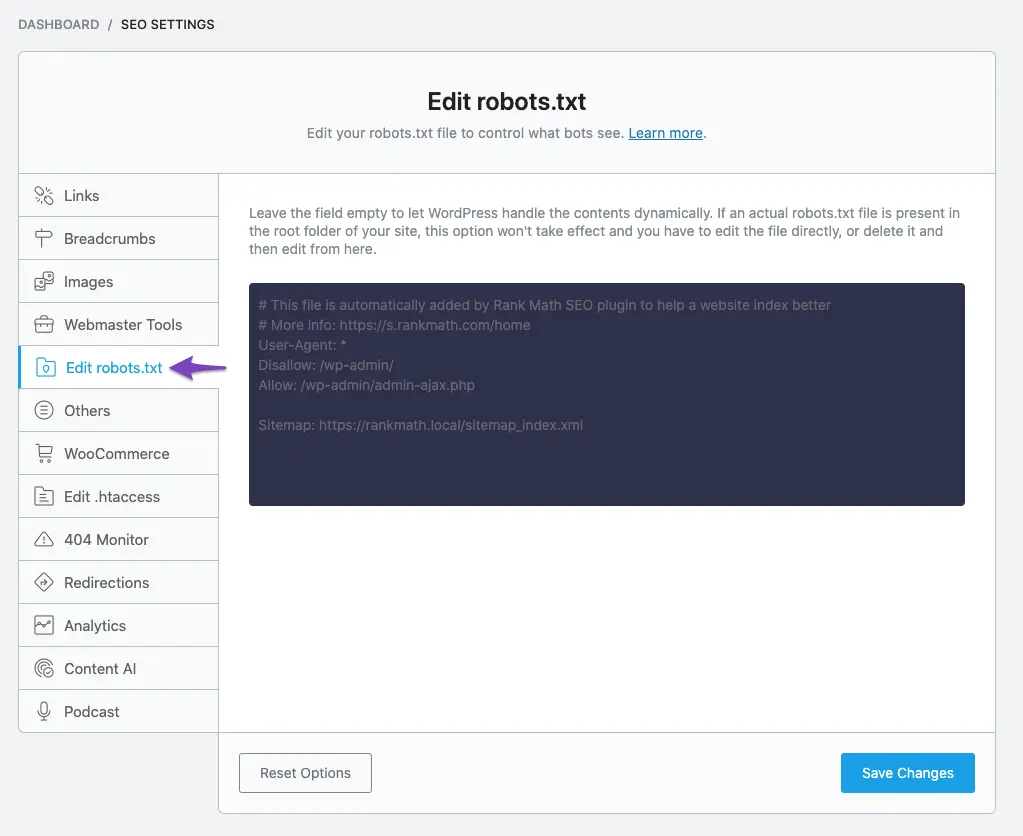

使用Rank Math設定Robots.txt

Rank Math同樣是一個WordPress SEO插件,與Yoast SEO類似,它也提供了Robots.txt的編輯功能。你可以在WordPress後台導航到Rank Math SEO> General Settings > Edit robots.txt,然後在這裡編輯你的Robots.txt。Rank Math的介面直觀易用,你可以輕鬆添加、編輯或刪除Robots.txt的規則。

藉由使用這些SEO插件,即使你不是一位開發者,也能輕鬆地編輯和管理你的Robots.txt。

Robots.txt對SEO的影響與策略應用

Robots.txt如何影響SEO

Robots.txt直接影響著搜尋引擎爬蟲如何爬取和索引你的網站,進而影響你的SEO排名。一個恰當設定的Robots.txt能確保你希望被搜尋引擎看到的內容被順利爬取,而你不希望被看到的內容則被適當地遮蔽。這有助於提高你網站的SEO表現,因為搜尋引擎將能夠更有效地找到和索引你的重要內容。

策略性地使用Robots.txt來優化SEO

你可以使用Robots.txt來引導搜尋引擎爬蟲專注在你最重要的內容上,同時避免爬取無關的或是重複的內容。這樣可以讓你的網站在搜尋引擎結果中有更好的排名。例如,你可能不希望搜尋引擎爬蟲爬取你的管理頁面或者某些實驗性的頁面,這時你就可以在Robots.txt中加入相關的規則來達成這個目的。

不過,要注意的是,雖然Robots.txt可以用來阻止搜尋引擎爬取特定的內容,但如果你的頁面被其他網站連結,該頁面的URL可能仍會出現在搜尋結果中,只是該頁面的內容描述可能不會出現,因為搜尋引擎無法爬取該頁面的內容。因此,如果你希望完全隱藏某些內容,可能需要採取其他的SEO技巧或設定。